4X_Pro пишет:Lisyca пишет:- это капец, отказаться от себя - это как вообще? Вот тут то и начинают защитные механизмы срабатывать, правда такое не часто встречается, что радует.

Тут еще сказывается то, что у меня личных убеждений, из-за которых я буду противостоять коллективу, существенно больше, чем у среднестатистического человека. Допустим, то же Непразднование. Если, скажем, предположить, что я пришел на работу, где с одной стороны, принято их праздновать с приглашением всего коллектива, с другой -- скидываться всем на подарки, я, будучи Непразднующим, откажусь делать и то, и другое. Вероятность того, что коллектив окажется понимающим и скажет "Ok, 4X_Pro у нас Непразднующий, поэтому в этих вопросах он не участвует" достаточно мала, скорее всего, начнется долгое и нудное противостояние, где они будут пытаться меня переделать, а я буду воображать себя религиозным мучеником, принимающим страдания за свою веру.

Это похоже на то, как коллектив, да и вообще друзья и знакомые (не все, конечно, часть), относятся к тому, что я соблюдаю пост. Правда, мучеником я себя не считаю, но раздражают те, у кого нет своей позиции, но мою надо раскритиковать. Собственно, игнор и мысленно послать в *опу и проблемы нет. Например, когда к родителям мужа в гости приезжаем, на столе нет ничего, что можно есть мне, только несколько видов мяса и вообще разная жирная и обильная пища, хотя они прекрасно знают про то, что я держу пост, просто считают, что я дурью маюсь. В общем, я не спорю и не убеждаю, не обижаюсь, и вообще не считаю, что они должны изменять свои привычки из-за меня, а просто привожу с собой еду и готовлю сама. А вот лишние разговоры меня раздражают, и те кто хочет меня пожалеть и посочувствовать тем более. Потому что я не мучаюсь, а наоборот мне нравиться, что в пост я могу не есть вредности и при этом мотивация исходит извне, а не мой личный каприз.

А на счет не скидываться - в чем проблема? Один раз убедительно высказать свою позицию подробно и пусть отвалят, им то что, в денежном выражении ни убытка, ни экономии, или волнует именно то, что будут за спиной обсуждать?

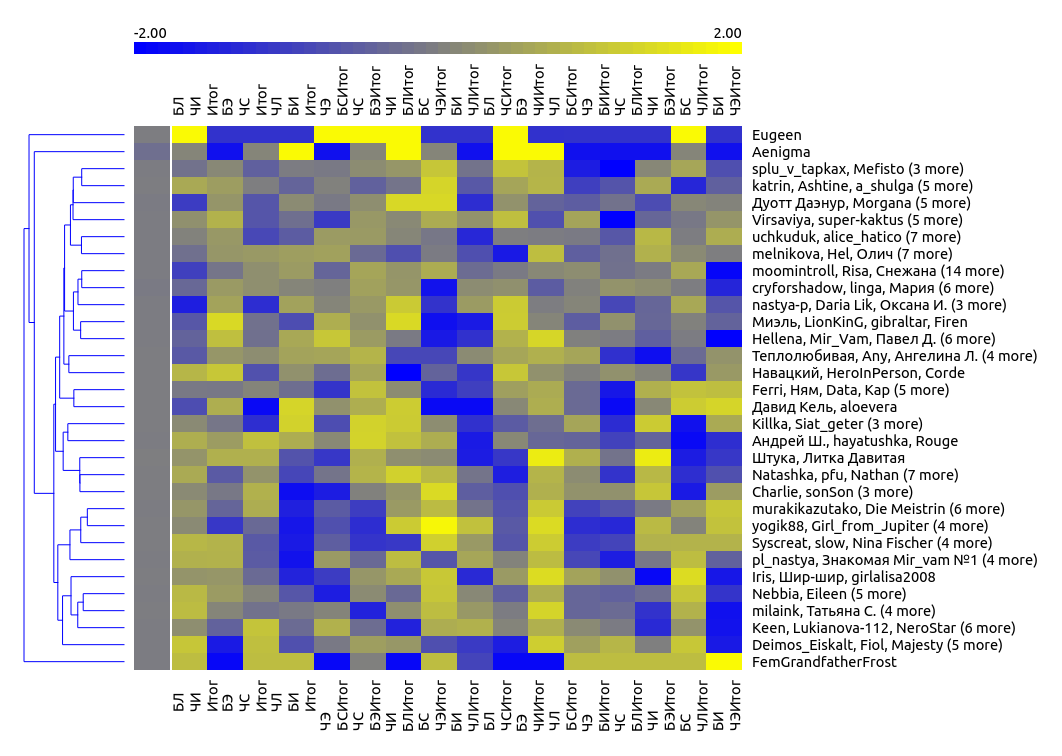

ЭСЭ